Ao ajudar a financiar compradores como OpenAI e CoreWeave, a Nvidia está moldando a demanda por seus próprios chips — juntamente com os riscos que vêm com isso.

No final de outubro, o cofundador e CEO da Nvidia, Jensen Huang, subiu ao palco na conferência anual GTC da empresa para fazer uma declaração tipicamente grandiosa. A Nvidia, ele proclamou, está “no epicentro da maior revolução industrial da história humana”, eclipsando o advento da máquina a vapor e da eletricidade. Ele prosseguiu desvendando uma impressionante variedade de parcerias: a Nvidia planeja construir 100.000 carros autônomos junto com a Uber e unir-se à Palantir para fornecer software e chips para acelerar a transferência de produtos dos armazéns até as portas das casas; ela também concebeu um projeto mostrando às hyperscalers [grandes provedores de nuvem] como construir “fábricas de IA”, data centers em escala gigantes que só operam em seu máximo potencial e eficiência implantando, adivinhe, sistemas da Nvidia.

O discurso de Huang animou tanto os fãs da Nvidia que eles enviaram sua capitalização de mercado às alturas, com um salto de 5% em um dia, de US$ 250 bilhões, um valor 60% maior do que o valor total da Boeing. O movimento fez da Nvidia a primeira empresa do mundo a atingir uma avaliação de US$ 5 trilhões. De acordo com a MarketBeat, 46 dos 47 analistas têm uma recomendação de “strong buy” [compra forte] ou “buy” [compra] para as ações da Nvidia.

Um pequeno coro de céticos extremamente perspicazes, no entanto, não tem tanta certeza de que tudo seja tão róseo quanto Huang e os investidores parecem acreditar. Suas preocupações se concentram em como a Nvidia está se esforçando para manter sua supremacia, montando o que nunca vimos antes nessa escala: uma superestrutura complexa que abrange investimentos e financiamento para seus próprios clientes, projetada para impulsionar e perpetuar a demanda por seus próprios produtos. A estratégia — centrada principalmente na OpenAI e na “neocloud” [nuvem de nova geração] CoreWeave — é tanto sobre engenharia financeira quanto sobre engenharia de computação acelerada.

Como diz Jay Goldberg, da Seaport Global Securities, que emitiu a única recomendação de “sell” [venda] para a Nvidia no mercado, “A Nvidia está comprando demanda aqui”. Lisa Shalett, diretora de investimentos da Morgan Stanley Wealth Management, diz que a questão tem tudo a ver com dívida excessiva, não da Nvidia, mas de seus clientes. “A Nvidia está em posição de sustentar clientes para que possa crescer”, afirma Shalett. “Está ficando cada vez mais complicado porque os que eles estão financiando são mais fracos, e a Nvidia está permitindo que eles assumam empréstimos.”

A Nvidia se recusou a comentar para esta reportagem. Mas para entender como este poderoso símbolo da nova economia americana chegou aqui, você precisa entender três coisas: a dinâmica de poder em jogo entre as grandes hyperscalers como Amazon, Microsoft, Alphabet e Meta que estão erguendo gigantescos data centers de IA; as neoclouds que surgem para desafiá-las; e o medo mais premente de Jensen Huang.

O caminho da Nvidia para o domínio da IA

Durante a maior parte de seus 32 anos de existência, a Nvidia se concentrou em fazer chips de gráficos 3D para o mercado de PC gaming — e lutou nos primeiros dias, em um momento ficando sem dinheiro. Em 1999, ela revelou uma GPU (graphics processing unit [unidade de processamento gráfico]) superavançada que gerava imagens lidando com computações complexas em uma velocidade muito maior que suas predecessoras. Uma série de avanços na década de 2000 permitiu um tipo de IA conhecido como “deep learning” [aprendizado profundo] — e permitiu que a tecnologia fizesse coisas com as quais havia lutado anteriormente — primeiro tradução, depois reconhecimento de imagem. Por volta de 2012, a Nvidia havia apostado totalmente em GPUs e outros hardware otimizados para IA, que ela acoplou ao seu software personalizado CUDA que capacita os desenvolvedores a escrever aplicações para seus chips revolucionários.

Uma vez que a OpenAI lançou o ChatGPT no final de 2022, o boom de IA estava começando, e a Nvidia se posicionou brilhantemente para surfar a onda. Suas GPUs foram classificadas como as mais poderosas da indústria e, crucialmente, as mais eficientes por unidade de consumo de energia na execução do número estupendo de cálculos matemáticos implantados na IA. No ano fiscal de 2023, ela obteve um modesto lucro de US$ 4,4 bilhões. Esse número disparou para US$ 86,6 bilhões nos últimos quatro trimestres, tornando a Nvidia a maior lucradora de tecnologia atrás da Alphabet (US$ 124,3 bilhões), Apple (US$ 112 bilhões), Microsoft (US$ 104,9 bilhões), e à frente da Amazon e Meta.

Ao contrário de high-fliers [empresas de alto voo] do passado que foram muito alardeadas e entraram em colapso — notavelmente os motores da bolha de telecomunicações do final dos anos 1990 e início dos anos 2000 — ninguém está questionando que a Nvidia faz montes de dinheiro. Mas é aparente que o colosso de chips é dependente de alguns clientes enormes. No segundo trimestre deste ano, a Nvidia coletou 52% de suas vendas de três clientes que não divulgou, mas que os analistas identificam como Microsoft, Amazon e Alphabet. Meta e Elon Musk (via xAI e Tesla) também são grandes compradores de seus sistemas. Diversificar internacionalmente não é fácil, especialmente porque o governo chinês cortou as importações dos chips de baixa potência da Nvidia como uma resposta na guerra comercial, e os controles de exportação da administração Trump bloquearam as vendas de suas GPUs mais cobiçadas e sofisticadas. No ano passado, a segunda maior economia do mundo contribuiu com mais de um em cada oito dólares de vendas por meio de clientes como Baidu e Alibaba. Esse número já vem diminuindo e está fadado a cair ainda mais se não desaparecer, potencialmente aumentando a dependência da Nvidia dos maiores dos grandes players.

Huang acredita que inclinar-se tão pesadamente sobre alguns compradores superpoderosos é perigoso. De acordo com uma fonte que tem sido ativa no desenvolvimento de infraestrutura de IA, o motivo principal da Nvidia é evitar o destino de quase todos os fornecedores de hardware de tecnologia: ser commoditized [transformado em commodity].

“Hardware é um negócio de baixa margem, e a Nvidia sabe que você só pode manter uma vantagem tecnológica em hardware por tanto tempo”, diz esta fonte. “Eles têm medo de ser commoditized como os fabricantes de CPUs [os “cérebros” básicos dos computadores atuais]. Eles têm medo de que seu poder de barganha decline ao longo do tempo e que suas enormes margens entrem em colapso.” No momento, a Nvidia é uma maravilhosa exceção no hardware de tecnologia. No ano fiscal de 2025, ela registrou fantásticas margens brutas de nearly 80%, superando facilmente a AMD, com pouco menos de 50%, para não mencionar a Intel, com 30%.

Até agora, a Nvidia deteve a mão superior. “Sua GPU é tão superior que tem um quase monopólio”, diz o analista Goldberg da Seaport. Como resultado, uma Amazon ou uma Meta não foram capazes de implantar o tremendo poder de negociação que seu tamanho imenso lhes dá contra seus fornecedores de hardware. As grandes hyperscalers estão se esforçando muito para recuperar a vantagem.

Como? Os principais players não querem apenas ser clientes da Nvidia; seu objetivo de longo prazo é competir com a Nvidia criando suas próprias alternativas internas. A Microsoft está trabalhando em uma versão apelidada de Maia, e a Amazon implantou duas — Trainium e Inferentia. O Google já mudou amplamente para seu próprio silicon [silício], que chama de TPU.

Toda essa competição provavelmente deprimirá os preços. “A maior parte da IA até hoje foi construída em um provedor de chips. É caro”, escreveu o CEO da Amazon, Andy Jassy, em seu relatório anual de 2024. “Não precisa ser tão caro quanto é hoje, e não será no futuro.” Os principais executivos da Microsoft também enfatizaram que querem seu próprio silicon para alimentar seus data centers. Gil Luria, chefe de pesquisa de tecnologia da D.A. Davidson, coloca de forma simples: “A Nvidia quer se diversificar para longe dos Quatro Grandes, e os Quatro Grandes querem se diversificar para longe deles.” (“Quatro Grandes” aqui significando Microsoft, Amazon, Google e Meta.)

Mas muitos outros players querem se diversificar no mundo da Nvidia. A AMD está se tornando um grande player em inference [inferência], onde a Nvidia domina; a Qualcomm está tentando entrar no jogo de chips de data centers, assim como uma série de startups de chips de IA como a Groq, que estão começando a ganhar alguma tração, especialmente no Oriente Médio. Até a OpenAI, que está forjando laços estreitos com a Nvidia, está simultaneamente apostando tudo em fazer seu próprio silicon enquanto tenta se diversificar para longe da Nvidia. Dylan Patel, que escreve a amplamente respeitada newsletter SemiAnalysis, escreveu em meados de novembro que o concorrente da OpenAI pode ser tão bom que a Microsoft pode optar por usá-lo em vez de seu próprio produto, Maia.

80%

As margens brutas da Nvidia no FY 2025, superando a AMD (50%) e a Intel (30%) por uma ampla margem

Então os relacionamentos são cada vez mais complicados, pois esses players fecham acordo após acordo. O maior cliente da CoreWeave de longe é a Microsoft; ela quer ampliar seu alcance para atender a OpenAI e outras startups de IA. A OpenAI, entretanto, é cliente da CoreWeave, investidora da CoreWeave e em breve será concorrente da CoreWeave uma vez que o consórcio Stargate entre em operação.

A CoreWeave encontrou um apoiador robusto na Nvidia — mas analistas se preocupam com sua dívida crescente.

Michael Nagle — Bloomberg/Getty Images

Mas dentro desta teia de relacionamentos, são dois que a Nvidia desenvolveu — com a OpenAI e a CoreWeave — que chamaram a atenção da multidão do “o que poderia dar errado”. “A Nvidia tem sido inteligente em sustentar outro ecossistema próprio para que possam competir com as grandes hyperscalers em capacidade de data centers”, diz a pessoa envolvida em infraestrutura de IA.

Para fazer isso, a Nvidia está usando algo semelhante ao “vendor financing” [financiamento do fornecedor]. É a prática de longa data e totalmente legítima de fazer empréstimos a clientes que os incentivam a comprar seus produtos — é como as montadoras impulsionam as vendas fornecendo empréstimos para carros. Funciona bem, desde que haja demanda real por seus produtos.

A abordagem da Nvidia pode ser caracterizada como um impulso por “demanda ‘direta’ ou ‘curada’”. A desvantagem dessa fórmula: O financiamento generoso pode desencadear empréstimos excessivos e empurrar a capacidade de computação de IA muito além do ponto onde a demanda pode alcançar. No entanto, é importante notar que a campanha da Nvidia não equivale ao notório “roundtripping” [viagem de ida e volta] que afundou telecoms como Nortel e Lucent, que fizeram grandes empréstimos a fornecedores de fibra ótica de telecomunicações em dificuldades para que eles pudessem comprar seus produtos, mesmo que estivessem apenas acumulando estoque não utilizado.

Até agora, o movimento mais ousado da Nvidia ao desafiar as gigantes é seu impressionante acordo com a OpenAI. Huang considera a inventora do ChatGPT, ainda privada, como a ponta de lança do novo paradigma e, por implicação, o maior cliente da Nvidia no futuro. Ele recentemente previu que a OpenAI se tornará a “próxima empresa hyperscale de vários trilhões de dólares”. Antes da nova parceria, a OpenAI estava apenas começando como uma hyperscaler por meio de sua participação no Stargate. Ela não operava data centers por conta própria e alugava capacidade dos Quatro Grandes, notadamente da Microsoft. A parceria com a Nvidia visa tornar a OpenAI um grande concorrente, além de sua condição de cliente, dos gigantes incumbentes.

Sob o acordo, anunciado no final de setembro, a Nvidia compraria até US$ 100 bilhões em ações da OpenAI, permitindo-lhe equipar numerosos data centers oferecendo uma surpreendente capacidade de 10 gigawatts a um custo total estimado de aproximadamente US$ 500 bilhões. A construção aconteceria em camadas, e para cada uma a Nvidia fornece US$ 10 bilhões em financiamento, a OpenAI contribui com US$ 40 bilhões, e um estimado US$ 30 bilhões é gasto em chips da Nvidia.

US$ 700 bilhões

Uma previsão conservadora do que os quatro grandes hyperscalers gastarão este ano e no próximo em infraestrutura de IA. Para obter mesmo um retorno decente de 15% apenas sobre essas despesas, eles precisariam embolsar um extra de US$ 105 bilhões por ano em lucros de IA, um número que parece inatingível.

Mas Luria adverte que muita coisa pode dar errado. A OpenAI precisa encontrar os US$ 40 bilhões extras necessários para cada parcela por conta própria. Essa é uma barreira alta. Até este ponto, a OpenAI conseguiu financiar suas operações levantando capital. Mas agora está entrando em uma nova era de grandes investimentos de capital ao mesmo tempo em que queima montes de dinheiro; no primeiro semestre deste ano, ela perdeu US$ 13,5 bilhões em apenas US$ 4,3 bilhões de receita. Um relatório recente sugere que a empresa terá perdas operacionais de US$ 74 bilhões em 2028 e não alcançará o equilíbrio até 2030. Portanto, é provável que a OpenAI precise pedir emprestado a maior parte dos US$ 400 bilhões adicionais.

A OpenAI fez agora compromissos totais de cerca de US$ 1,4 trilhão para seus projetos de infraestrutura de IA, incluindo US$ 300 bilhões a serem construídos pela Oracle (que incorpora enormes compras de GPUs da Nvidia). Dada a frenética onda de otimismo em torno da OpenAI, ela pode conseguir tomar emprestado centenas de bilhões para acumular todas essas GPUs. Mas, como observa Nick Del Deo, analista da MoffettNathanson, “A OpenAI é um modelo de negócios não comprovado.” Significativamente, a Nvidia é apenas uma investidora de capital até agora. Ela não ofereceu seu balanço para garantir a imensa dívida que a OpenAI precisará para impulsionar o programa. Adicionando mais uma complexidade ao cenário competitivo: a OpenAI não quer ser completamente dependente da Nvidia também; ela está conversando com outros fornecedores de chips e até começou esforços para projetar seus própri chips sob medida.

A Nvidia garantiu sua segunda parceria de destaque com a CoreWeave. Ela é de longe a maior das “neoclouds” que estão instalando rapidamente infraestrutura de IA. A ex-mineradora de criptomoedas, no entanto, está lutando sob uma montanha de dívidas da qual os analistas são céticos sobre sua capacidade de “escalar” para sair. Então a Nvidia está dando à empresa muita ajuda para comprar seus chips — em quantidades muito maiores do que seriam possíveis sem esses bilhões em apoio. A Nvidia investiu US$ 250 milhões para reforçar a conturbada IPO da CoreWeave este ano e detém uma participação acionária de mais de 6%. A CoreWeave, como a OpenAI, é até agora uma casa “somente Nvidia”. Ela já opera 33 data centers, todos detendo as GPUs de seu grande apoiador, e ostenta um backlog [ordens em carteira] de US$ 56 bilhões em contratos de infraestrutura de IA. A Nvidia também está usando seu músculo para ajudar a CoreWeave a atrair startups promissoras que, sem o apoio da fabricante de chips, não poderiam levantar o financiamento para alugar espaço da hyperscaler em ascensão. No final de setembro, a Nvidia assinou um acordo garantindo a compra de US$ 6,3 bilhões em capacidade de computação se a CoreWeave não puder alugá-la ou vendê-la. “É como ser cosigner [fiador] em um empréstimo”, diz Del Deo. De acordo com uma fonte familiarizada com o pensamento da CoreWeave, esse apoio capacitará a operadora a fornecer capacidade de computação para empresas como Mistral e Cohere que poderiam evoluir para grandes histórias de sucesso de IA.

“A Nvidia está em posição de sustentar clientes para que possa crescer. Está ficando cada vez mais complicado porque os que eles estão financiando são mais fracos, e a Nvidia está permitindo que eles assumam empréstimos.”

Lisa Shalett, Diretora de Investimentos, Morgan Stanley Wealth Management

Para a Nvidia, a CoreWeave se encaixa no molde da OpenAI: atrair compradores que usavam centros da Microsoft ou Amazon — alimentados por GPUs que compraram da Nvidia — para as instalações da CoreWeave. Em um excelente relatório de 80 páginas sobre a CoreWeave lançado em março, Del Deo elogia sua experiência técnica e atendimento ao cliente. O problema potencial: Quando a CoreWeave assina um contrato com uma grande hyperscaler financeiramente sólida que precisa de muita capacidade além do que pode lidar internamente, esses pagamentos de aluguel são “money good” [dinheiro certo]. A CoreWeave pode levantar financiamento, pois tem certeza de que o cliente (digamos, Microsoft) pagará.

Mas como parte do crescimento de seu próprio complexo e do novo complexo da Nvidia, a CoreWeave está assumindo novatos que queimam dinheiro e carecem de ratings de crédito. O maior exemplo, de fato, é seu acordo com a própria OpenAI — outra indicação de quão profundamente a rede de acordos da Nvidia está interligada. Os termos exigem que a CoreWeave forneça US$ 22,4 bilhões em capacidade de infraestrutura de IA, certamente funcionando com GPUs da Nvidia, ao longo de cerca de cinco anos. Com base nas grandes expectativas para a OpenAI, a CoreWeave já financiou parte do acordo por meio de empréstimos bancários. Mas os empréstimos foram caros, a mais de 8%. “O acordo com a OpenAI e outros clientes non-investment-grade [abaixo do grau de investimento] aumenta os riscos para a CoreWeave”, conclui Del Deo.

Além disso, a CoreWeave, como a OpenAI, abriga grandes déficits de fluxo de caixa e está pegando pesadamente emprestado para financiar sua pegada crescente. Seu cofundador e CEO, Michael Intrator, afirma que está dirigindo um “carro de corrida, não uma minivan”, e que “a dívida é o combustível para esta empresa”. Mas poderia também ser sua ruína?

Um fiasco da dívida?

Para ver onde estão os perigos, é importante entender quem deve toda essa dívida e a quais partes. As conchas de data centers físicos são geralmente construídas por empresas de real estate, principalmente REITs (real estate investment trusts [fundos de investimento imobiliário]). Elas financiam os projetos com empréstimos de construção fornecidos por, digamos, bancos ou empresas de private equity, e alugam o espaço para as hyperscalers. As maiores entre elas podem usar seu próprio fluxo de caixa para comprar os sistemas que preenchem os campuses, mas uma CoreWeave ou OpenAI não tem os recursos e deve tomar os fundos emprestados de uma variedade de credores.

O novo galáxia auto montada da Nvidia é fortemente povoada com a OpenAI e outras empresas que não provaram que podem ganhar dinheiro com base em suas ofertas de IA, mas estão prontas para arcar com grandes empréstimos por seus impérios de infraestrutura de IA.

Mais uma vez, se a demanda dos clientes corporativos e de aplicativos da Microsoft se mostrar muito menor que o antecipado, ela simplesmente continuará pagando o aluguel do prédio para o REIT e os juros e principal dos empréstimos para o equipamento de tecnologia para aquele credor. Nenhum risco aí. O novo galáxia auto montada da Nvidia é fortemente povoada com os tipos da OpenAI e startups que não provaram que podem ganhar dinheiro com base em suas ofertas de IA, mas estão prontas para arcar com grandes empréstimos para criar e expandir impérios de infraestrutura de IA.

A CoreWeave e a OpenAI estão de fato assinando contratos de arrendamento com seus clientes de IA para alugar aquela iminente enxurrada de capacidade de computação à medida que ela entra em operação. Mas para continuar alugando, esses clientes precisam obter lucros ricos com o que é anunciado como o maior salto tecnológico e multiplicador de força para a lucratividade de todos os tempos. Se isso não acontecer, o mercado pode ficar inundado por data centers parcialmente vazios e por GPUs que securitizaram os empréstimos e serem recuperadas pelos credores, enviando todos esses chips não utilizados da Nvidia de volta ao mercado. Nesse cenário, as novas hyperscalers apoiadas pela Nvidia não conseguirão pagar o aluguel dos campuses dos prédios, nem os juros e principal da dívida que comprou as GPUs. Isso poderia atingir os empréstimos para data centers e a demanda pelas GPUs da Nvidia.

Esse cenário não está dissuadindo os verdadeiros crentes. “A Nvidia ficou à frente vez após vez”, diz um executivo de um grande cliente da Nvidia que não estava autorizado a falar publicamente. “Eles continuam encurtando os ciclos de produtos. Todos estão tentando acompanhar sua contínua inovação.”

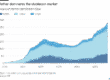

Mas qualquer observador lúcido da indústria tem que pelo menos levantar uma sobrancelha sobre quanto dinheiro está inundando a IA, e quão pouco retorno houve até agora. No total, os quatro grandes players gastarão cerca de US$ 330 bilhões em infraestrutura de IA em 2025, de acordo com suas próprias previsões, e todos estão prometendo aumentos significativos no próximo ano. O Citigroup prevê que o valor para todas as hyperscalers no próximo ano chegará a US$ 490 bilhões. Então, vamos tomar a visão conservadora de que os Quatro Grandes gastarão US$ 700 bilhões no período de dois anos. Para obter mesmo um retorno decente de 15% apenas sobre essas despesas, eles precisariam embolsar um extra de US$ 105 bilhões por ano em lucros de IA. Esse adicional de mais de US$ 100 bilhões equivale a quase um terço dos US$ 350 bilhões em lucros líquidos totais GAAP que eles geraram em seus últimos quatro trimestres.

Observa um executivo que levantou grandes somas para infraestrutura de IA no passado: “Compartilho a preocupação de que quantias massivas de capital estão entrando nisso sem uma linha clara de visão sobre a lucratividade. Temos uma noção de economias de produtividade e avanços na pesquisa. Mas quais são os killer apps [aplicativos matadores] que vão gerar valor massivo? Ainda não sabemos.” Este executivo faz a pergunta que Huang pode ponderar quando para de vender e pensa profundamente: “Se o retorno sobre todo aquele capital for decepcionante, para onde vai a dor?” Enquanto a narrativa do hype da IA continuar, a máquina de fazer dinheiro da Nvidia continuará zunindo. Mas se a história mudar, a Nvidia sentirá a dor — e seus investidores também.

Fonte: Fortune

Traduzido via DeepSeek