Nenhuma empresa se beneficiou mais da febre da inteligência artificial do que a Nvidia, atualmente a companhia mais valiosa do mundo. Ao longo dos últimos três anos, investidores impulsionaram suas ações às alturas, na crença de que seu domínio sobre o mercado de chips de IA é inabalável. Fabricantes de chips rivais e startups, igualmente, tentaram abrir espaço em seu negócio, com pouco sucesso.

Agora, porém, um dos maiores clientes da Nvidia surgiu como seu concorrente mais feroz até o momento. Neste mês, o Google, que foi pioneiro nos algoritmos “transformer” que sustentam a atual onda de IA, lançou o Gemini 3, um modelo de ponta que supera os de seus maiores rivais, incluindo a OpenAI, na maioria dos benchmarks. Crucialmente, o Gemini 3 foi treinado inteiramente nos próprios chips do Google, chamados tensor-processing units (TPUs), que a empresa começou a oferecer a terceiros como uma alternativa muito mais barata às graphics-processing units (GPUs) da Nvidia. No mês passado, a Anthropic, uma desenvolvedora de modelos, anunciou planos de usar até 1 milhão de TPUs do Google em um acordo supostamente avaliado em dezenas de bilhões de dólares. Relatos de que a Meta, outro gigante de tecnologia com grandes ambições em IA, também está em conversas para usar os chips do Google em seus data centers até 2027 fizeram a Nvidia perder mais de US$ 100 bilhões em valor de mercado, cerca de 3% do total, desde o fechamento do pregão de ontem.

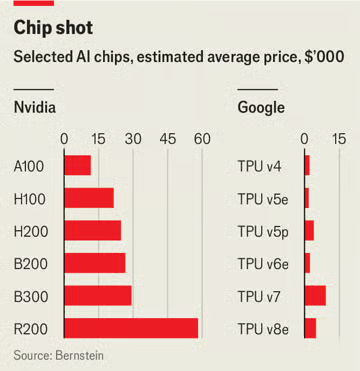

Os clientes da Nvidia têm um forte incentivo para explorar alternativas mais baratas. A Bernstein, uma empresa de pesquisa em investimentos, estima que as GPUs da Nvidia respondem por mais de dois terços do custo de um rack típico de servidores de IA. As TPUs do Google custam entre metade e um décimo de um chip equivalente da Nvidia (ver gráfico). Essas economias se acumulam. A Bloomberg Intelligence, outro grupo de pesquisa, projeta que os gastos de capital do Google cheguem a US$ 95 bilhões no próximo ano, com quase três quartos desse montante sendo usados para treinar e operar modelos de IA.

Outros gigantes de tecnologia, incluindo Amazon, Meta e Microsoft, também vêm desenvolvendo processadores personalizados, e no mês passado a OpenAI anunciou uma colaboração própria com a Broadcom, uma designer de chips, para desenvolver seu próprio silício. Mas nenhum avançou tanto quanto o Google. A empresa começou a projetar seus próprios chips há mais de uma década. Naquele momento, os engenheiros do Google estimaram que, se os usuários utilizassem um novo recurso de busca por voz em seus celulares por apenas alguns minutos por dia, a companhia precisaria dobrar sua capacidade de data centers, uma previsão que impulsionou o desenvolvimento de um processador mais eficiente, adaptado às necessidades do Google. A empresa já está na sétima geração de TPUs. O banco de investimento Jefferies estima que o Google produzirá cerca de 3 milhões desses chips no próximo ano, quase metade do número de unidades da Nvidia.

Para outros clientes da Nvidia, porém, migrar para os chips do Google não será simples. A vantagem da Nvidia reside em parte na CUDA, a plataforma de software que ajuda programadores a tirar proveito de suas GPUs. Desenvolvedores de IA se acostumaram a ela. E, enquanto o software em torno das TPUs foi criado tendo em vista os próprios produtos do Google, a CUDA foi concebida para atender a uma ampla gama de aplicações. Além disso, na avaliação de Jay Goldberg, analista do setor na Seaport Research Partners, pode haver um limite para o grau de disposição do Google em vender suas TPUs, preferindo em vez disso direcionar seus potenciais clientes para seu serviço de computação em nuvem, onde pode obter margens maiores. Para dificultar a vida de seus concorrentes em IA, o Google também pode ser tentado a manter os preços de seus chips elevados.

Tudo isso pode ajudar a explicar por que Jensen Huang, o chefe da Nvidia, não parece especialmente preocupado. Ele descreveu o Google como “um caso muito especial”, dado que começou a desenvolver chips muito antes da atual onda de IA, e descartou outros esforços como “super adoráveis e simples”. Ele também está apostando na flexibilidade. A arquitetura transformer que sustenta os modelos de IA de hoje ainda está evoluindo. As GPUs, que foram originalmente desenvolvidas para jogos de computador, são altamente adaptáveis, permitindo que pesquisadores de IA testem novas abordagens. A Nvidia já não parece tão invulnerável quanto antes. Mas sua força não deve ser subestimada. ■

Fonte: The Economist

Traduzido via ChatGPT